Es kommt erst mal nicht: Zum Release von iOS 15 werden weder die Nacktbild-Erkennung in iMessage noch der Foto-Abgleich starten, der ursprünglich lokale Fotos vor dem Hochladen in Apples iCloud mit einer Datenbank von digitalen Fingerabdrücken bekannter Missbrauchsbilder abgleichen sollte. Apple verschiebt die umstrittene Funktion.

Update vom 3. September 2021: Die kritische Berichterstattung übers Apples diskutable Funktion zur Missbrauchs-Erkennung trägt Früchte. In einer aktuellen Stellungnahme unterrichtet der iPhone-Hersteller die Öffentlichkeit über eine Verschiebung der Funktion (Quelle: iphone-ticker.de). Konkret heißt es:

„Wir haben bereits Pläne für Funktionen angekündigt, die dazu beitragen sollen, Kinder vor Straftätern zu schützen, die Kommunikationstools nutzen, um sie anzuwerben und auszubeuten, und die Verbreitung von Material über sexuellen Kindesmissbrauch einzudämmen. Aufgrund des Feedbacks von Kunden, Interessengruppen, Forschern und anderen haben wir beschlossen, uns in den kommenden Monaten mehr Zeit zu nehmen, um Anregungen zu sammeln und Verbesserungen vorzunehmen, bevor wir diese äußerst wichtigen Funktionen zum Schutz von Kindern veröffentlichen.“

Originaler Kommentar von Frank Ritter:

Apple ergreift Maßnahmen gegen Kinderpornographie. Das ist grundsätzlich ein positives Anliegen, aber: das Gegenteil von gut ist gut gemeint. Denn Apple scannt dafür verdachtslos Daten auf den Geräten der Nutzer:innen – auch und vor allem jener Mehrheit, die unbescholten ist. Schlimmer noch: Die Systeme öffnen Missbrauch, etwa durch autoritäre Regime, Tür und Tor. Das ist fatal.

Worum es geht

Am Donnerstag stellte Apple seine Pläne zum Schutz von Kindern auf der „Child Safety“-Sektion auf der Website vor. Inhalte auf iPhones, iPads, Mac-Rechnern und in der iCloud können demnach später im Jahr im Sinne des Kinderschutzes durchsucht werden, ihre Anzeige blockiert, deren Besitz Behörden mitgeteilt werden. Die Änderungen betreffen zunächst Nutzerinnen und Nutzer in den USA.

Kurz zusammengefasst, was Apple angekündigt hat:

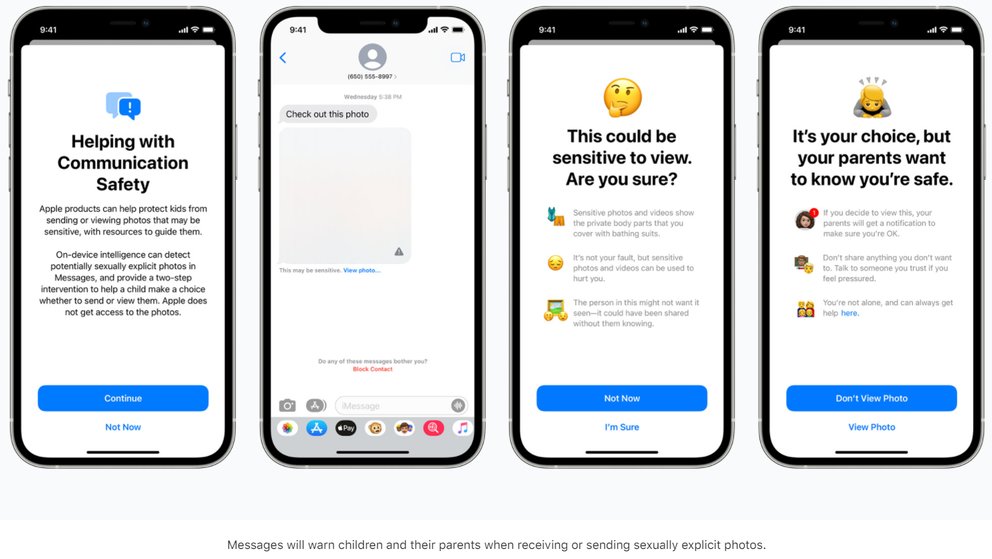

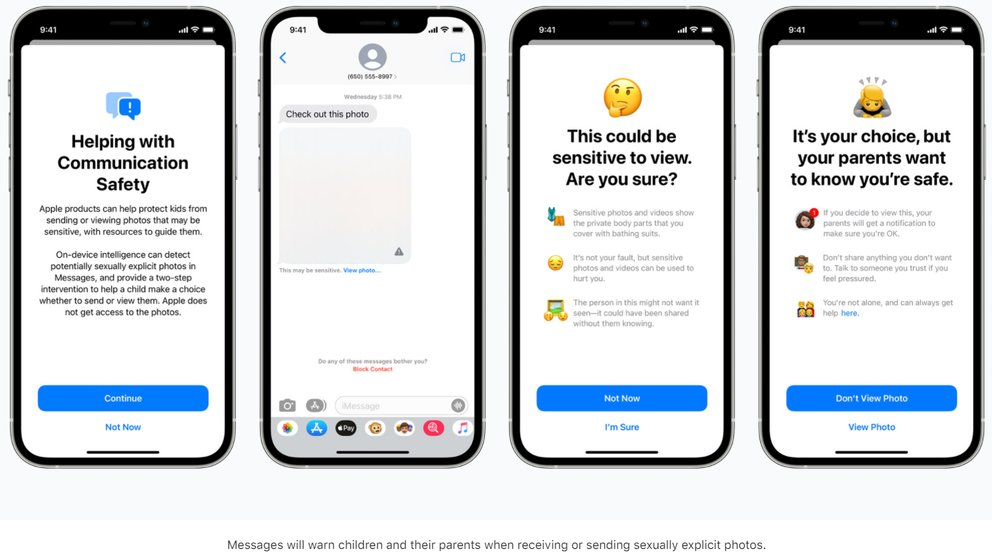

iMessage: Werden auf Geräten mit iOS 15, iPadOS 15, WatchOS 8 oder macOS Monterey Bilder gesendet oder empfangen, die beispielsweise Nacktheit bei Minderjährigen zeigen, werden diese zunächst nicht angezeigt. Die Einschätzung, ob die Inhalte Entsprechendes zeigen, nimmt das Gerät auf Basis von lokal ausgeführten Maschinenlern-Algorithmen durch. Die/der Nutzende kann in einer Warnmeldung bestätigen, dass diese Inhalte dennoch angezeigt beziehungsweise gesendet werden. Ist die/der Nutzende unter 13 Jahre und Teil einer Familiengruppe, werden die Eltern informiert. Die Funktion ist „opt-in“, muss von Eltern also gesondert aktiviert werden.

Fotos/iCloud: Um die Verbreitung von Kinderpornographie zu verringern, werden Bilder, die in iCloud hochgeladen werden, mit einer Datenbank bekannter kinderpornographischer Bilder gegengeprüft, die von der US-NGO National Center for Missing and Exploited Children (NCMEC) gepflegt wird. Dieser Abgleich findet nicht in der Cloud, sondern über so genannte „NeuralHashes“ auf dem Gerät des Nutzers statt, die Ähnlichkeiten anhand von spezifischen Bildmerkmalen identifizieren können, ohne dass die Bilder selbst verglichen werden. Fehlmeldungen seien laut Apple möglich, aber extrem selten. Sollte eine kritische Menge an entsprechenden Bildern in einem iCloud-Konto überschritten werden und Apple feststellen, dass der Vorwurf gerechtfertigt ist, werde der Fall von Apple geprüft, gegebenenfalls das Nutzerkonto gesperrt und die Behörden informiert. Betroffene sollen die Möglichkeit erhalten, Einspruch einzulegen.

Siri/Suche: Nutzende werden gewarnt, wenn sie nach kinderpornographischen Inhalten suchen.

Warum die neuen Funktionen zu weit gehen

Natürlich ist die Erstellung und Verbreitung von Kinderpornographie schändlich, gehört verfolgt und bestraft. Aber wie weit sollte man gehen? Ich bin der Auffassung, dass das Überprüfen aller Bilder, die Nutzer auf ihren Geräten haben und in die Cloud geladen werden, dafür zu weit geht. Ja, auch, wenn dies dazu führen würde, dass sich das Material etwas weniger verbreiten würde, einige Besitzer:innen solcher Daten aufgrund des Verfahrens tatsächlich gefasst werden könnten.

Der erste wichtige Grund: Ich möchte über mein Gerät bestimmen, insbesondere auf die Daten, die darauf gespeichert sind und die damit verschickt oder empfangen werden. Ich möchte nicht fürchten, dass ein Algorithmus die über die Geräte laufende Kommunikation darauf hin überprüft, ob die verschickten Inhalte statthaft sind, die von mir geschossenen oder verschickten Bilder nach irgendeiner Definition anrüchig. Ich möchte nicht, dass man auch nur überlegen muss, ein Selfie vom FKK-Strand, ein Foto von den in der Badewanne planschenden Kindern oder, Gott bewahre, ein konsensuelles Foto primärer oder sekundärer Geschlechtsteile an die oder den Partner zu senden. In dem Moment, da dieses Nachdenken erfolgt, ist die Schere im Kopf da – dann hat man die Souveränität über die Technik verloren, die man besitzt.

Es ist wichtig zu verstehen, dass der Abgleich der Daten in iCloud nur auf Basis von Hashes von bekannten Bildern passiert, und dies auch nur auf dem Endgerät. Eigene Bilder werden nur beim Versand mit iMessage bewertet, und dann auch nur unter bestimmten Umständen und mit überschaubaren Konsequenzen, siehe oben. Ich glaube Apple, dass die Funktionen mit den besten Absichten und viel technischem Sachverstand implementiert wurden, dass sie so wenig invasiv wie möglich sind. Aber das Vertrauen wird so zerstört, dass Apple in den vergangenen Jahren mit seinem Fokus auf Privatsphäre und Datenschutz sowohl in der Architektur der eigenen Hard- und Software als auch in der Werbung, aufgebaut hat. Das ist ein Problem, denn die Technologiebranche braucht Apple in dieser Rolle, als Gegengewicht zu den Daten-Giganten Google und Facebook.

Es gibt aber einen weiteren schwerwiegenden Grund, Apples Vorkehrungen abzulehnen. Die jüngere Geschichte hat gezeigt, dass das Thema Kinderpornographie, so schwerwiegend und entsetzlich es sein mag, immer wieder für Technologie oder Technologieregulierung missbraucht wird, die ihren Nutzern Freiheiten entzieht und sie in ein System der Überwachung führt, Stichworte: Vorratsdatenspeicherung, Uploadfilter und dergleichen. Das Argumen Kinderpornographie stand stets nur der Anfang einer Entwicklung, fungierte als ein dankbarer Türöffner in Form jenes Verbrechens, auf dessen Bekämpfung sich alle einigen können. Du und ich und Tante Lise haben ja nichts zu verbergen und irgendwie ist es ja auch dubios, wenn man Maßnahmen gegen Kinderpornographie nicht gut findet, oder?

Problematisch daran: Apple schafft eine Infrastruktur, die für Zensur bis in die Geräte der Nutzer hinein missbraucht werden kann. Wenn die Werkzeuge erst einmal da sind, werden zwangsweise Begehrlichkeiten bei staatlichen Akteuren geweckt, die zu bekämpfenden Inhalte auszuweiten. Als nächstes wäre politischer Extremismus dran ist, danach Inhalte, auf die ein Copyright gilt. Und schließlich solche, die in manchen Teilen der Welt als anrüchig, anderswo als Ausdruck individueller Freiheit gelten. Darstellungen von Homosexualität. Bilder vom Massaker am Tian’anmen-Platz. Memes über die Führung autoritär geführter Staaten.

Das Ende dieser und ähnlicher Entwicklungen kann eine totalitäre Überwachung sämtlicher Kommunikation sein, die Zensur und Unterdrückung unliebsamer Themen, die soziale Ächtung und Verfolgung jener, die darüber diskutieren möchten. Nein, das ist keine Dystopie, sondern in China längst Realität.

Wer garantiert, dass es bei Bildern bleibt, nicht auch Texte, Videos oder Gespräche, bei denen das Telefon daneben liegt? Wer kontrolliert, dass die Hashliste wirklich nur Kinderpornographie enthält? Wer schützt uns davor, dass diese Features in totalitären Regimes missbraucht werden? Einzig und allein Apple? Das reicht nicht.

Mehr Informationen

apple.com

appleprivacyletter.com

eff.org

Was Apple sagt

Wir haben auch Apple zum Thema gesprochen. Im persönlichen Gespräch wurde deutlich gemacht, dass die Kinderschutz-Funktionen zusammen mit Experten entwickelt wurden, auf apple.com/child-safety technisch genau dokumentiert sind und zunächst nur in den USA ausgerollt werden. Ob und in Zusammenarbeit mit welchen Behörden ähnliches in anderen Ländern passiert, ist zum aktuellen Zeitpunkt noch nicht klar, der gesetzliche Rahmen muss dafür zunächst geklärt werden. Apple legt zudem Wert auf die Feststellung, dass auch in Zukunft seitens dritter kein direkter Zugriff auf die Daten seitens möglich ist, die verschlüsselt in iCloud liegen. Der Abgleich findet auch hier auf dem Gerät statt, die mit einer heruntergeladenen Version der NCMEC-Datenbank abgeglichen wird. Zum Kinderschutz in iMessage betont Apple, dass die Nutzung ein reines auf dem Gerät stattfindendes „Opt-In“-Feature ist, das Eltern für ihre Familiengruppe explizit aktivieren müssen.